Tauche ein in die faszinierende Welt von GPT-Systemen und erfahre, wie künstliche Intelligenz und Deep-Learning-Modelle menschenähnliche Texte generieren. Entdecke, was hinter Begriffen wie Transformer, neuronale Netzwerke und Embeddings steckt, und lerne, wie diese Technologien unser Verständnis von Sprache und Kommunikation revolutionieren.

Inhaltsverzeichnis

Einführung in die Technologie

Generative Pre-trained Transformer, kurz GPT, ist eine künstliche Intelligenz (KI) basierend auf maschinellem Lernen, speziell einer Art von Deep-Learning-Modellen namens „Transformer“. Die Technologie dahinter ermöglicht es, komplexe Sprachstrukturen und Texte zu verstehen und zu generieren.

Training eines GPT-Systems

Ein GPT-System wird in zwei Phasen trainiert: Pre-Training und Fine-Tuning. Im Pre-Training lernt das Modell die grundlegenden Muster und Strukturen der Sprache, indem es riesige Mengen an Text analysiert und versucht, die Wahrscheinlichkeit des nächsten Wortes in einem Satz vorherzusagen. Beim Fine-Tuning wird das Modell auf spezifische Aufgaben oder Themenbereiche zugeschnitten, indem es mit entsprechenden Texten weiter trainiert wird.

Reaktion auf Eingaben

Ein GPT-System reagiert auf Eingaben, indem es auf Basis der gelernten Sprachmuster und Strukturen versucht, den wahrscheinlichsten Text zu generieren, der auf die Eingabe folgt. Hierbei nutzt es statistische Modelle, um die Wahrscheinlichkeit der nächsten Wörter oder Sätze zu bestimmen.

Statistische Modelle

GPT-Systeme verwenden neuronale Netze, um die Wahrscheinlichkeiten von Wörtern und Sätzen zu berechnen. Diese Netze lernen aus den Trainingsdaten und erstellen darauf basierend statistische Modelle, die den Zusammenhang zwischen Wörtern, Sätzen und Kontexten abbilden.

Nutzung von statistischen Modellen

Die Verwendung von statistischen Modellen ermöglicht es dem GPT-System, die Wahrscheinlichkeit zu bestimmen, welche Wörter oder Sätze am besten zum Kontext passen. Indem es die gelernten Muster und Wahrscheinlichkeiten verwendet, kann das System kohärente und sinnvolle Antworten auf Eingaben generieren.

Fehlendes echtes Wissen

Ein GPT-System hat kein „echtes“ Wissen über Fakten und Daten, da es lediglich Muster in Texten erkennt und diese reproduziert. Es lernt aus den Trainingsdaten, kann jedoch nicht zwischen wahren und falschen Informationen unterscheiden.

Unfähigkeit, richtig und falsch zu erkennen

Da ein GPT-System lediglich auf statistischen Modellen und Wahrscheinlichkeiten basiert, kann es nicht zwischen richtig und falsch unterscheiden. Es generiert Texte, die kohärent und plausibel erscheinen, aber nicht unbedingt wahr oder korrekt sind.

Der plappernde stochastische Papagei

Der Begriff „plappernder stochastischer Papagei“ beschreibt treffend die Funktionsweise eines GPT-Systems. Wie ein Papagei wiederholt das System Muster und Strukturen, die es gelernt hat, ohne jedoch ein Verständnis für die Bedeutung der Worte oder die Wahrheit der Informationen zu haben.

Dem stochastischen Papagei möchte ich noch etwas Raum gegen.

Das Problem der LLM ist folgendes und wurde treffend von Emily Bender in Ihrem Paper „On the Dangers of Stochastic Parrots:Can Language Models Be Too Big?“ zusammengefasst:

„Der von einer LM generierte Text basiert nicht auf einer kommunikativen Absicht, einem Modell der Welt oder einem Modell des Geisteszustands des Lesers. Das kann auch nicht sein, denn die Trainingsdaten beinhalteten nie den Austausch von Gedanken mit einem Zuhörer, und die Maschine ist auch nicht in der Lage, dies zu tun.“

Der Begriff „Stochastic Parrots“ ist übrigens nicht neu und mir seit mindestens 2021 so geläufig als ich das erste mal das Paper von Ted Underwood gelesen habe, welches sich mit Gefahren von LLMs als Positionspapier für die Princeton University beschäftigt hat (Mapping the Latent Spaces of Culture).

Ein aktueller Stand zum „stochastischen Papagei“

In einer Welt, die zunehmend von Daten und Technologie angetrieben wird, hat eine kürzlich in arXiv veröffentlichte Studie von Charles Jin und Martin Rinard, „Evidence of Meaning in Language Models Trained on Programs„, neue Horizonte in unserem Verständnis der künstlichen Intelligenz eröffnet. Die Forschung hinterfragt die gängige Annahme, dass Sprachmodelle, die auf Texten trainiert werden, nur oberflächliche statistische Korrelationen erfassen und stellt fest, dass diese Modelle tatsächlich eine tiefergehende, semantische Bedeutung lernen können.

Die Studie hebt hervor, dass durch das Training eines Transformer-Modells auf einem Korpus von Programmen und deren Spezifikationen, die Modelle in der Lage sind, abstrakte Semantiken zu erfassen, die weit über das hinausgehen, was ihre Ausbildung vermuten lässt. Diese Fähigkeit, „zwischen den Zeilen zu lesen“, könnte eine Revolution in Bereichen wie der automatischen Code-Generierung, Fehlerbehebung und sogar der KI-Ethik bedeuten.

Fehlende Quellenangabe

GPT-Systeme kennen keine Quellen, da sie lediglich Textmuster und Strukturen aus den Trainingsdaten erlernen und diese reproduzieren. Sie sind nicht in der Lage, spezifische Quellen für die von ihnen generierten Informationen zu nennen oder auf konkrete Nachfragen zu verweisen.

Nicht existierende Quellen

Ein GPT-System kann dennoch Quellen oder Referenzen in seinen Antworten nennen, aber diese sind möglicherweise nicht echt oder existieren nicht. Das liegt daran, dass das System keine direkte Kenntnis von den Quellen hat und lediglich die in den Trainingsdaten erlernten Muster und Strukturen verwendet.

Menschliches Wissen vs. statistischer Wahrscheinlichkeit

Der Hauptunterschied zwischen menschlichem Faktenwissen und der statistischen Wahrscheinlichkeit, wie sie von GPT-Systemen verwendet wird, liegt in der Art und Weise, wie Informationen erworben, gespeichert und angewendet werden.

Menschliches Faktenwissen bezieht sich auf das Verständnis von konkreten Informationen, Daten und Zusammenhängen, die durch Lernen, Erfahrung und Beobachtung erworben werden. Menschen speichern dieses Wissen in ihrem Langzeitgedächtnis und können es aktiv abrufen und anwenden, um Probleme zu lösen, Entscheidungen zu treffen oder Diskussionen zu führen. Faktenwissen ermöglicht es Menschen, auf der Grundlage von verifizierten Informationen zu argumentieren und logische Schlussfolgerungen zu ziehen.

GPT-Systeme hingegen basieren auf statistischer Wahrscheinlichkeit und Mustererkennung. Sie verfügen nicht über „echtes“ Wissen im Sinne von menschlichem Faktenwissen. Stattdessen analysieren sie riesige Mengen an Textdaten und lernen, die Struktur und die Muster der menschlichen Sprache zu imitieren. Sie generieren Texte, indem sie auf der Grundlage der analysierten Daten Wahrscheinlichkeiten berechnen und so Wörter oder Sätze auswählen, die am besten zum gegebenen Kontext passen. Da GPT-Systeme keine Quellen kennen und keine Informationen verifizieren können, sind ihre Antworten und Texte lediglich das Ergebnis der Mustererkennung und Wahrscheinlichkeitsberechnung, nicht aber das Ergebnis eines tiefen Verständnisses von Fakten oder Zusammenhängen.

Zusammenfassend lässt sich sagen, dass menschliches Faktenwissen auf dem Verständnis und der Anwendung von konkreten Informationen basiert, während GPT-Systeme auf statistischer Wahrscheinlichkeit und Mustererkennung beruhen, ohne ein tiefes Verständnis von Fakten oder Zusammenhängen zu besitzen.

Begriffserklärungen, für ein besseres Verständnis:

Künstliche Intelligenz (KI)

Künstliche Intelligenz bezieht sich auf die Schaffung von Computersystemen, die menschenähnliche Intelligenz und kognitive Fähigkeiten aufweisen, wie beispielsweise Problemlösung, Spracherkennung, Lernen und Anpassung. KI kann in verschiedene Kategorien eingeteilt werden, wie zum Beispiel:

- Schwache KI (narrow AI): Spezialisierte Systeme, die nur bestimmte Aufgaben ausführen können, wie Spracherkennung oder Bildanalyse.

- Starke KI (general AI): Systeme, die menschenähnliche Intelligenz und kognitive Fähigkeiten aufweisen und problemlos zwischen verschiedenen Aufgaben wechseln können.

- Superintelligenz: Hypothetische Systeme, die menschliche Intelligenz weit übertreffen und in nahezu allen Bereichen überlegen sind.

Deep-Learning-Modelle

Deep Learning ist ein Teilbereich des maschinellen Lernens, der auf künstlichen neuronalen Netzwerken basiert, insbesondere solchen mit vielen Schichten (tiefen Netzwerken). Deep-Learning-Modelle können komplexe Muster und Zusammenhänge in Daten erkennen und sind besonders leistungsfähig bei der Verarbeitung von großen Datenmengen, wie beispielsweise Bilder, Sprache oder Texte. Einige gängige Deep-Learning-Modelle sind:

- Convolutional Neural Networks (CNNs): Für Bildverarbeitung und -erkennung

- Recurrent Neural Networks (RNNs): Für sequenzielle Daten wie Zeitreihen oder Texte

- Generative Adversarial Networks (GANs): Für das Generieren von neuen Daten, die denen in den Trainingsdaten ähneln

Transformer

Ein Transformer ist ein spezielles Deep-Learning-Modell, das für die Verarbeitung von sequenziellen Daten, insbesondere Texten, entwickelt wurde. Es basiert auf der Idee der Selbst- und Kreuz-Aufmerksamkeit (self-attention and cross-attention) und kann dadurch effizienter und besser mit langen Textsequenzen umgehen als beispielsweise RNNs. Transformer sind die Grundlage von GPT-Systemen.

Pre-Training und Fine-Tuning

- Pre-Training: In dieser Phase lernt ein GPT-System grundlegende Sprachstrukturen und Muster, indem es riesige Mengen an Text analysiert und versucht, die Wahrscheinlichkeit des nächsten Wortes in einem Satz vorherzusagen. Dabei entsteht ein allgemeines Sprachmodell.

- Fine-Tuning: Nach dem Pre-Training wird das Modell auf spezifische Aufgaben oder Themenbereiche zugeschnitten, indem es mit entsprechenden Texten weiter trainiert wird. Dadurch erhält das Modell eine größere Fähigkeit, in einem bestimmten Kontext oder auf spezielle Fragen zu reagieren.

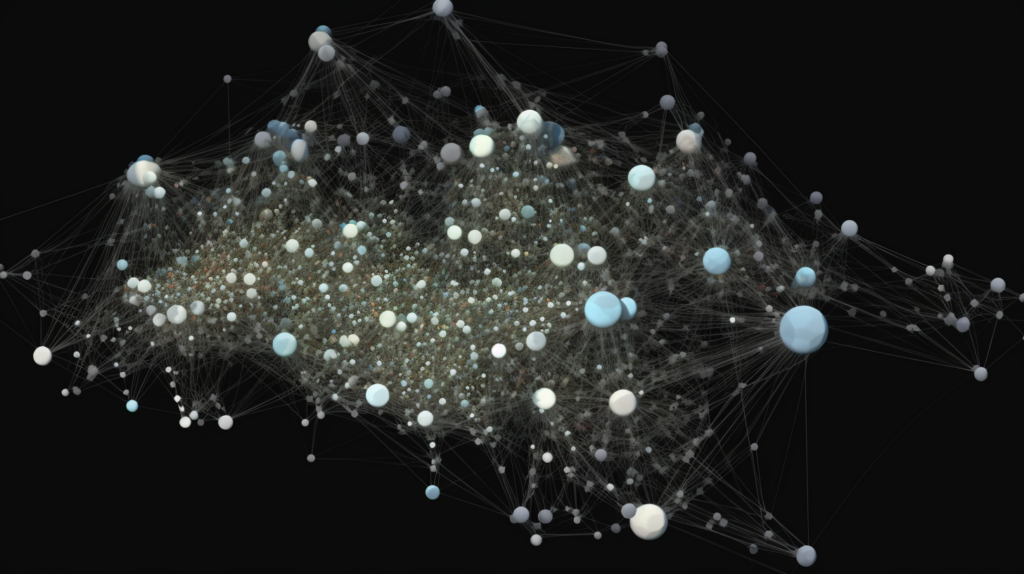

Neuronale Netzwerke

Neuronale Netzwerke sind eine Art von künstlichen Intelligenz-Modellen, die von der Struktur und Funktion des menschlichen Gehirns inspiriert sind. Sie bestehen aus miteinander verbundenen Knoten (Neuronen), die Informationen verarbeiten und weiterleiten können.

Neuronale Netzwerke lernen aus Trainingsdaten, indem sie die Stärke der Verbindungen zwischen den Neuronen anpassen, um Muster und Zusammenhänge in den Daten zu erkennen. Sie sind in verschiedenen Architekturen verfügbar, wie zum Beispiel Convolutional Neural Networks (CNNs), Recurrent Neural Networks (RNNs) oder Transformer.

Statistische Modelle

GPT-Systeme nutzen statistische Modelle, die auf neuronalen Netzwerken basieren, um die Wahrscheinlichkeit von Wörtern und Sätzen in einem bestimmten Kontext zu berechnen. Diese Modelle lernen aus den Trainingsdaten und erstellen darauf basierend eine Art Sprachmodell, das den Zusammenhang zwischen Wörtern, Sätzen und Kontexten abbildet. Im Fall von GPT handelt es sich um ein tiefes, auf Transformer-Architektur basierendes neuronales Netzwerk, das die Wahrscheinlichkeiten für Wortsequenzen unter Berücksichtigung des Kontexts berechnet.

Embeddings: Das Geheimnis hinter ChatGPT

Eine wichtige Komponente von ChatGPT und anderen Transformer-Modellen sind die sogenannten Embeddings. Diese ermöglichen es dem Modell, Wörter und ihre Bedeutungen in vektorieller Form zu repräsentieren und so Vorhersagen für den nächsten Teil einer Textsequenz zu treffen.

Transformer und Aufmerksamkeit (Attention)

Transformer-Modelle basieren auf dem Konzept der Selbst-Aufmerksamkeit (self-attention), das den menschlichen kognitiven Prozessen ähnelt. Im Bereich der natürlichen Sprachverarbeitung (Natural Language Processing, NLP) spielen Transformer eine wichtige Rolle, da sie komplexe Zusammenhänge in Texten erkennen und analysieren können.

Embeddings und ihre Bedeutung

Embeddings sind eine Art der Vektorrepräsentation, die Wörter oder Textfragmente in einem mehrdimensionalen Raum abbilden. Sie reduzieren die Dimensionalität der ursprünglichen Textdaten und schaffen so eine kompaktere Darstellung, die vom Modell leichter verarbeitet werden kann. Diese vektorielle Repräsentation hilft dem Modell, Zusammenhänge zwischen Wörtern und ihren Bedeutungen zu erfassen, was für eine präzise Vorhersage von Texten unerlässlich ist.

Verwendung von Embeddings in ChatGPT

ChatGPT nutzt Embeddings, um Wörter und Textfragmente in Kategorien einzuteilen und ihre Bedeutungen in einem vektoriellen Raum zu repräsentieren. Diese Kategorisierung erleichtert die Verarbeitung und Analyse von Texten, da das Modell sich auf die Beziehungen zwischen den Kategorien konzentrieren kann, anstatt jedes Wort einzeln zu betrachten. Dabei verwendet ChatGPT sogenannte Sub-Wörter, um Text auf einer granularen Ebene zu repräsentieren.

Zusammengefasst

Embeddings sind ein zentraler Bestandteil von ChatGPT und anderen maschinellen Lernmodellen wie Empfehlungsalgorithmen oder Klassifikationsmodellen. Sie ermöglichen es dem Modell, Texte und ihre Bedeutungen effizienter zu verarbeiten und Vorhersagen zu treffen. Die Implementierung von Embeddings in OpenAI’s ChatGPT trägt dazu bei, dass das Modell Wörter basierend auf Kategorien und ihrer numerischen Beziehung zu diesen Kategorien interpretieren kann, was eine präzise Analyse und Vorhersage von Texten ermöglicht.

Wer mehr dazu lesen will, schaut hier oder hier.

Fazit: Sinnvolle Nutzung von GPT-Systemen

GPT-Systeme sind beeindruckende Technologien, die komplexe Sprachstrukturen verstehen und generieren können. Sie sind jedoch keine unfehlbaren Informationsquellen, sondern vielmehr plappernde stochastische Papageien, die auf Wahrscheinlichkeiten und statistischen Modellen basieren.

Um GPT-Systeme sinnvoll zu nutzen, ist es wichtig, die Grenzen ihrer Fähigkeiten zu verstehen und darauf zu achten, dass im Eingabeprompt alle wichtigen Informationen enthalten sind. Das Modell generiert lediglich einen Text auf Basis der ihm zur Verfügung stehenden Informationen und kann keine Garantie für die Richtigkeit oder Vollständigkeit der generierten Texte geben. Daher sollte man stets kritisch prüfen, ob die von einem GPT-System bereitgestellten Informationen korrekt und plausibel sind, und gegebenenfalls zusätzliche, verlässliche Quellen zurate ziehen.

(geschrieben mit Unterstützung von ChatGPT)

2 Antworten auf „Generative Pre-trained Transformer (GPT): Ein plappernder stochastischer Papagei“

Vieles davon habe ich auch gelernt, bei ChatGPT durchschnittliche Fehlerquote 20%, bei Zitaten über 70%, und obwohl eine amerikanische Juraprüfung bestanden sein soll, bei Deutschen Gerichtsurteilen +80% Fehlerquote.

Danke für die vielen verständlichen. Hintergrundinformationen.